怎樣深入淺出大數據分析-創新互聯

這篇文章主要為大家分析了怎樣深入淺出大數據分析的相關知識點,內容詳細易懂,操作細節合理,具有一定參考價值。如果感興趣的話,不妨跟著跟隨小編一起來看看,下面跟著小編一起深入學習“怎樣深入淺出大數據分析”的知識吧。

“大數據”這個詞兒已經在 IT 圈蔓延到各個領域,如果真要刨根問底的問一句“如何實現大數據分析”,恐怕是 IT

圈里的好些人也一時半會兒解釋不清楚吧。所以嘗試把大數據分析這個事做個深入淺出的剖析還是很有意義的。仁者見仁智者見智,能力所限,表達如有不準確的地方希望你能用包容的心態多理解和指導。

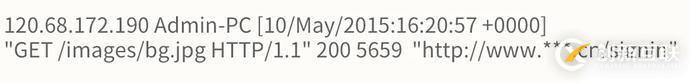

首先,用5秒鐘的時間掃描一下下面的這段內容吧:

知道上面是一段日志文件的片段的請舉手。敢問閣下您是一位受人尊敬的碼農吧?

看上面內容像天書的請舉手。請不要懷疑自己的能力,證明你是一個正常人,你的人生依然充滿希望和光明。

如果把上面的日志信息歸納如下,看起來是不是有點感覺了。

每當你訪問一個網站時,從你打開網站首頁開始,到你離開那個網站,只要網站愿意,你的一舉一動就會不停的產生類似上面這樣日志記錄,無數人的訪問會產生大量的訪問記錄,這個網站的“用戶訪問情況大數據”就這樣產生了。

接著思考,這些用戶訪問情況的大數據有什么價值呢?

沒錯!做網站用戶行為分析呀,了解用戶在網站上的動向、喜好,然后給用戶推薦更他更有可能感興趣的內容,為網站的運營決策提供數據參考等等,這個過程用一句帶點技術范兒的話總結就是:“日志掘金“。

日志掘金就是大數據分析的一個具體的應用場景。因為原始的日志文件(數據源)的信息是大而全的,而且結構有些復雜不易讀懂,所以日志掘金就像淘金一樣,從茫茫的數據海洋中,通過過濾、清洗,篩出有價值的關鍵信息—— KPI(黃金)。

那么繼續思考,如何通過技術實現從“數據源”過濾出“KPI”呢?下面是一個簡要的數據掘金流程圖,請稍微耐點心看看(圖下的文字解讀會讓你柳暗花明又一村):

用戶上網產生的行為被“日志文件”記錄下來,因為網站的訪問量很大,所以產生的日志文件也很大,為了能夠更高效的對這個文件進行分析,所以把它保存到一個叫“

HDFS

”的分布式文件系統中。這個過程中一份完整的“日志文件”會被拆分成n個小文件(按照每個小文件64MB等分),拆分后的每個小文件會再復制2個備份(n個小文件就變成了3n個),然后將這些小文件保存到“

HDFS

”系統的劃分出來的存儲節點上(一個存儲節點可以簡單理解為一臺電腦),保存的過程中同一份小文件和它的拷貝要保存在不同的存儲節點上(目的是為了防止某幾臺電腦壞了,沒有備份的話就會造成文件缺失)。

008.png953x550 55.5 KB

通過上面的過程,接下來從一個大日志文件中查找數據就演變為可以利用一群計算節點(計算機),同時從n個小文件中并行的查找數據了,然后再將每個節點查找的結果進行合并匯總,這個過程就是 MapReduce 數據清洗。

這個過程有點復雜,舉個栗子:從一個包含一組單詞的文件中(理解為“日志文件”)統計每個單詞出現的次數。首先將一個大文件拆分為三個小文件,然后分別統計每個小文件中每個單詞出現的次數,最后匯總每個小文件統計的結果。

經過 MapReduce 數據清洗之后,從一個數據結構不規則、大而全的日志文件中提取出需要的關鍵指標數據了,請注意提取后的數據依然保存在HDFS中。

這篇文章主要為大家分析了怎樣深入淺出大數據分析的相關知識點,內容詳細易懂,操作細節合理,具有一定參考價值。如果感興趣的話,不妨跟著跟隨小編一起來看看,下面跟著小編一起深入學習“怎樣深入淺出大數據分析”的知識吧。

另外有需要云服務器可以了解下創新互聯scvps.cn,海內外云服務器15元起步,三天無理由+7*72小時售后在線,公司持有idc許可證,提供“云服務器、裸金屬服務器、高防服務器、香港服務器、美國服務器、虛擬主機、免備案服務器”等云主機租用服務以及企業上云的綜合解決方案,具有“安全穩定、簡單易用、服務可用性高、性價比高”等特點與優勢,專為企業上云打造定制,能夠滿足用戶豐富、多元化的應用場景需求。

文章題目:怎樣深入淺出大數據分析-創新互聯

文章鏈接:http://m.newbst.com/article12/dpejgc.html

成都網站建設公司_創新互聯,為您提供軟件開發、App開發、App設計、定制網站、響應式網站、域名注冊

聲明:本網站發布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創新互聯

- 微信小程序和公眾號的區別 2016-09-18

- 公眾號軟文代寫價格怎么算? 2014-02-09

- 【微信公眾號運營目的】微信公眾號如何累積客戶? 2022-05-30

- 微信公眾號運營的幾個小技巧 2022-08-08

- 如何做好微信公眾號引流? 2014-03-13

- 微信公眾號運營之數據分析 2022-11-17

- 運營企業微信公眾號的10個秘訣 2021-06-13

- 微信公眾號搜索排名的九大規則是什么? 2015-09-06

- 怎么樣申請企業微信公眾號 2015-03-05

- 微信公眾號的二次開發是什么? 2014-05-23

- 常用的推廣微信公眾號的幾個方法 2022-05-28

- 微信公眾號運營該如何推廣? 2022-08-02