Python爬蟲如何抓取多個URL寫入本地文件

這篇文章主要介紹了Python爬蟲如何抓取多個URL寫入本地文件的相關知識,內容詳細易懂,操作簡單快捷,具有一定借鑒價值,相信大家閱讀完這篇Python爬蟲如何抓取多個URL寫入本地文件文章都會有所收獲,下面我們一起來看看吧。

成都創新互聯專注于福山企業網站建設,響應式網站開發,成都商城網站開發。福山網站建設公司,為福山等地區提供建站服務。全流程按需開發網站,專業設計,全程項目跟蹤,成都創新互聯專業和態度為您提供的服務

1. Pycharm中運行Scrapy

windows環境下cmd中通過scrapy startproject 項目名,創建scrapy項目

修改Run…中的Script path為cmdline.py文件路徑F:\programs\python\Lib\site-packages\scrapy\cmdline.py

Parameters為crawl 爬蟲文件名

working directory為scrapy項目所在文件夾

每次執行該run命令即可運行scrapy

2.items.py

class Csdn02Item(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

title = scrapy.Field()#標題

updatetime = scrapy.Field()#發表時間

readcount = scrapy.Field()#閱讀數

author = scrapy.Field()#作者

ranking = scrapy.Field()#博客排名

curl = scrapy.Field()#博文鏈接

context = scrapy.Field()#博文內容

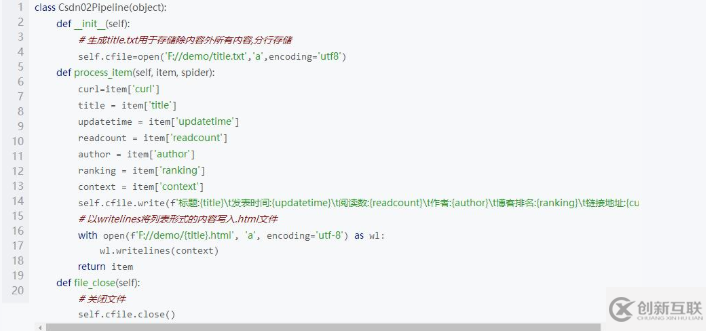

3.pipelines.py

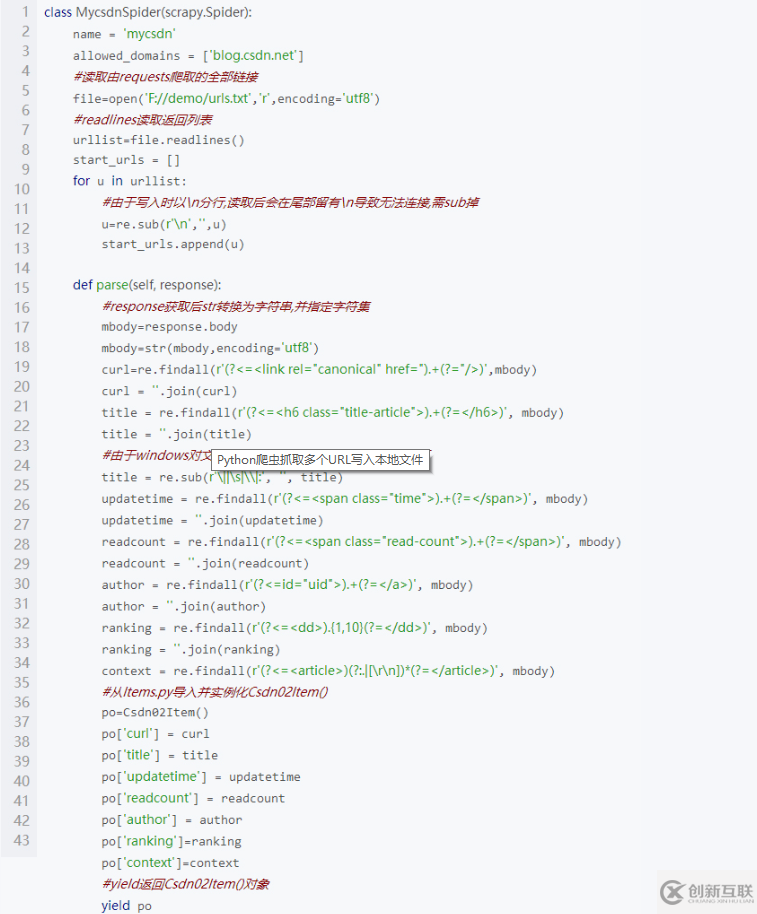

4.自定義的爬蟲代碼mycsdn.py

關于“Python爬蟲如何抓取多個URL寫入本地文件”這篇文章的內容就介紹到這里,感謝各位的閱讀!相信大家對“Python爬蟲如何抓取多個URL寫入本地文件”知識都有一定的了解,大家如果還想學習更多知識,歡迎關注創新互聯行業資訊頻道。

分享文章:Python爬蟲如何抓取多個URL寫入本地文件

本文地址:http://m.newbst.com/article40/jocdho.html

成都網站建設公司_創新互聯,為您提供品牌網站制作、手機網站建設、網站導航、動態網站、品牌網站建設、全網營銷推廣

聲明:本網站發布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創新互聯

- 什么是虛擬主機,什么是綁定域名? 2016-11-05

- 新手選擇虛擬主機的五大因素 2022-10-08

- 虛擬主機與云服務器 2021-02-14

- 網站建設時虛擬主機和服務器應該如何選擇? 2016-11-07

- 虛擬主機空間有哪種類型 2016-10-13

- apache虛擬主機中設置泛域名解析的方法 2022-10-03

- 如何選購虛擬主機 2022-07-10

- 企業網站制作一定要選好虛擬主機 2021-11-14

- 虛擬主機的優缺點有哪些? 2016-11-14

- 為什么支持JSP的虛擬主機那么少? 2016-10-24

- 企業網站應該如何選擇虛擬主機? 2016-05-16

- 如何用虛擬主機做SEO優化 2023-04-06