實戰:利用KNIME建立SparkMachinelearning模型1:開發環境搭建

1、Knime Analytics 安裝

創新互聯建站于2013年成立,先為武江等服務建站,武江等地企業,進行企業商務咨詢服務。為武江企業網站制作PC+手機+微官網三網同步一站式服務解決您的所有建站問題。

從官方網站下載合適的版本 https://www.knime.com/downloads

將下載的安裝包在安裝路徑解壓 https://www.knime.com/installation-0

下圖是knime啟動后的歡迎頁面

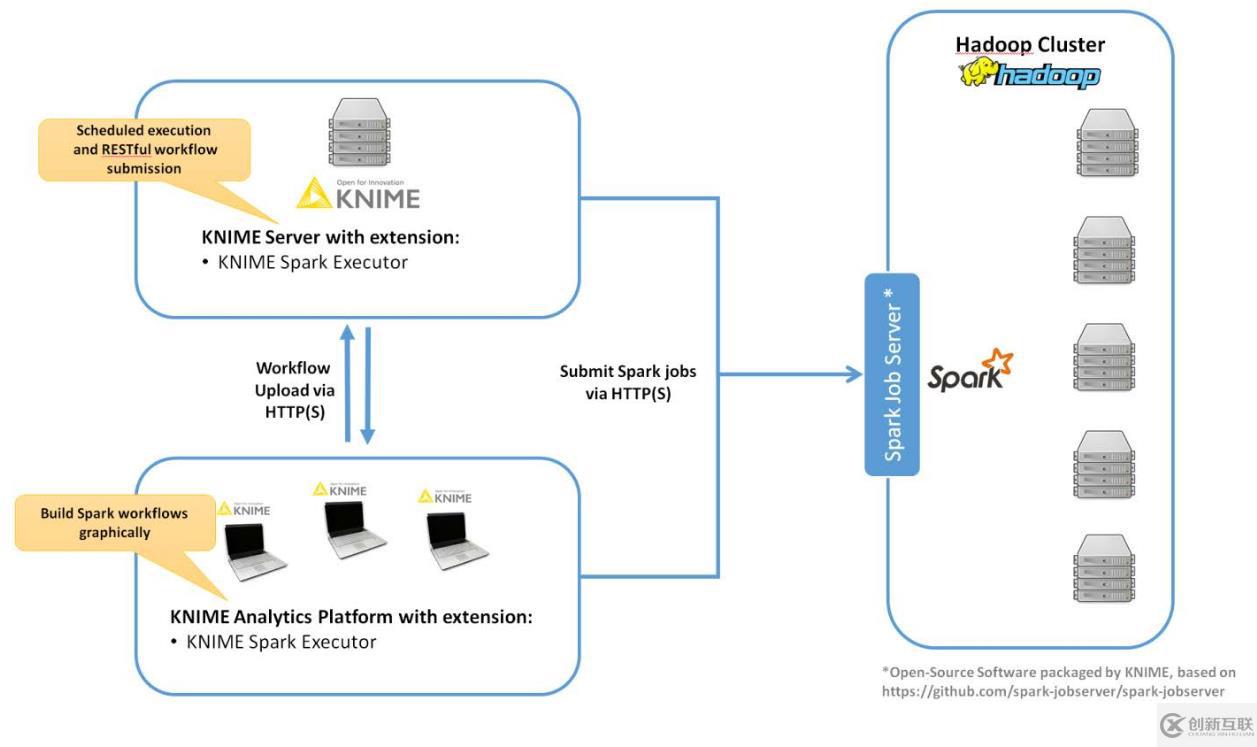

要與spark集×××互,需要在Knime中安裝KNIME? Extension for Apache Spark。并在Hadoop集群邊界節點或能夠執行spark-submit的節點安裝Spark Job Server。架構圖如下:

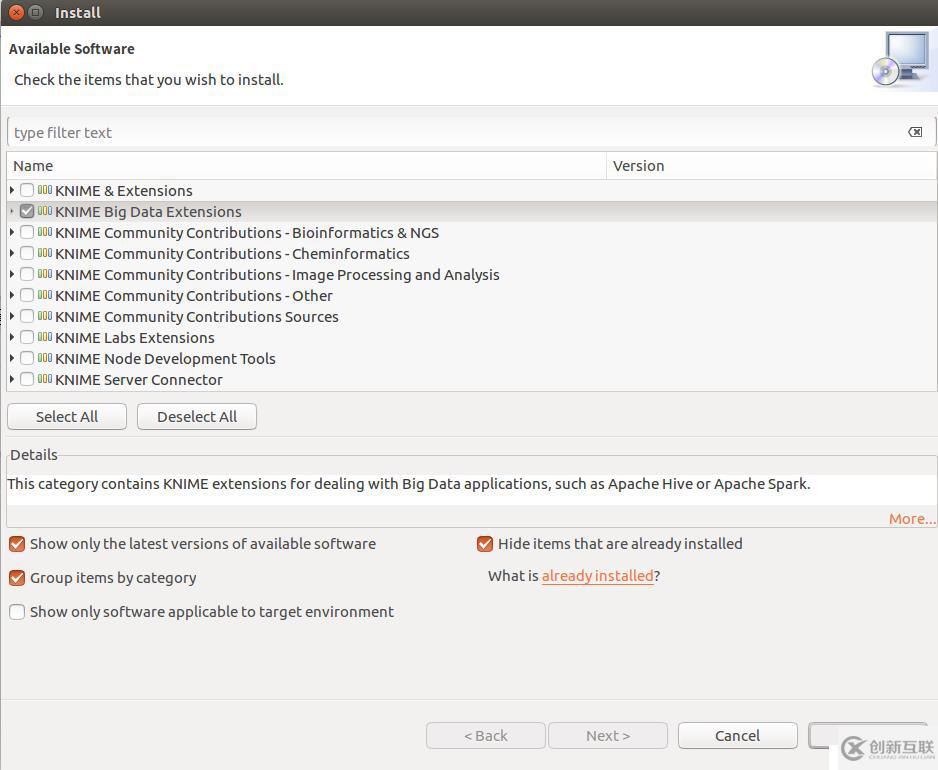

2、KNIME? Extension for Apache Spark 安裝

在KNIME Analytics 中點擊File->Install KNIME extensions選中KNIME Big Data Extensions,點擊Next安裝。

3、SPARK JOB SERVER安裝

以下步驟以Centos 6.5 + CDH 5.7 為例

3.1 下載spark job server

$ wget http://download.knime.org/store/3.5/spark-job-server-0.6.2.3-KNIME_cdh-5.7.tar.gz

3.2 login as root or su root

3.3 安裝

# LINKNAME=spark-job-server # useradd -d /opt/${LINKNAME}/ -M -r -s /bin/false spark-job-server # su -l -c "hdfs dfs -mkdir -p /user/spark-job-server ; hdfs dfs -chown -R spark-job-server /user/spark-job-server" hdfs # cp spark-job-server-0.6.2.3-KNIME_cdh-5.7.tar.gz /opt # cd /opt # tar -xvf spark-job-server-0.6.2.3-KNIME_cdh-5.7.tar.gz # ln -s spark-job-server-0.6.2.3-KNIME_cdh-5.7 ${LINKNAME} # chown -R spark-job-server:spark-job-server ${LINKNAME} spark-job-server-0.6.2.3-KNIME_cdh-5.7 |

3.4 開機啟動

# ln -s /opt/${LINKNAME}/spark-job-server-init.d /etc/init.d/${LINKNAME} #chkconfig --levels 2345 ${LINKNAME} on |

3.5 編輯environment.conf

設置master,例如

master = "spark://ifrebdplatform1:7077"

設置Default settings for Spark contexts: context-settings

3.6 編輯設置settings.sh

設置SPARK_HOME,本例默認正確,不做改變

設置LOG_DIR,如果不用默認設置的目錄的話

3.7 根據喜好編輯log4j-server.properties

3.8 啟動spark job server

/etc/init.d/${LINKNAME} start

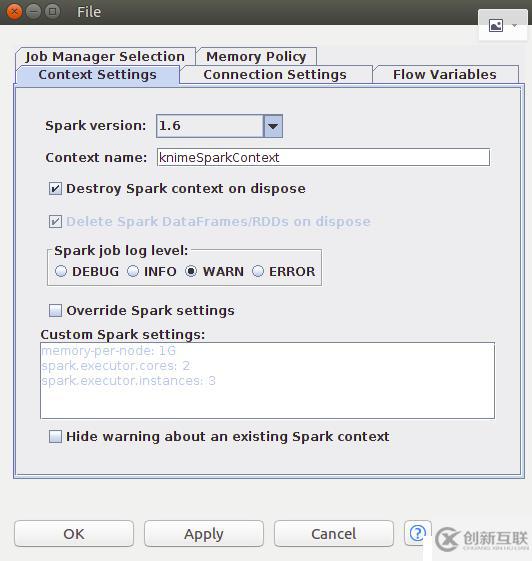

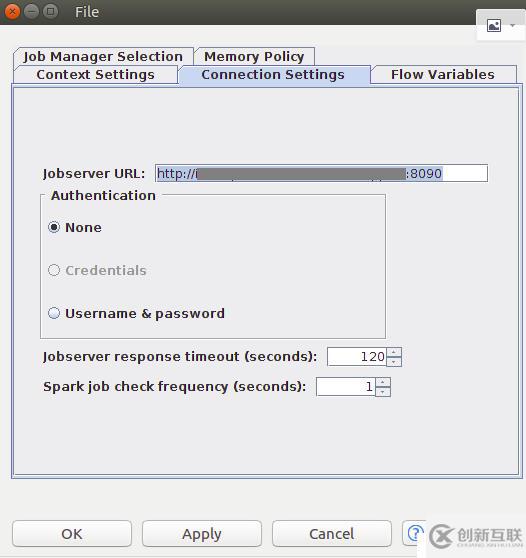

3.9 在knime 添加create spark context 節點測試鏈接

右擊create spark context 節點,點擊Execute執行

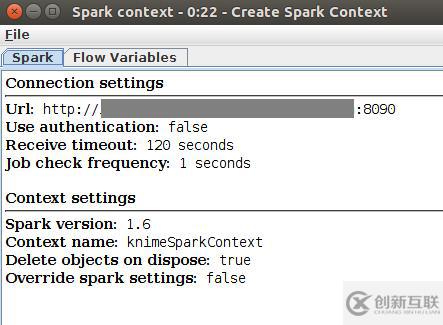

右擊create spark context 節點,點擊Spark Context,查看結果

未完待續......

分享文章:實戰:利用KNIME建立SparkMachinelearning模型1:開發環境搭建

分享路徑:http://m.newbst.com/article46/gpjehg.html

成都網站建設公司_創新互聯,為您提供Google、網站設計、外貿建站、云服務器、定制網站、微信小程序

聲明:本網站發布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創新互聯

- 百度的收錄情況取決于哪幾點 2013-05-08

- 那些做法導致百度不收錄 2017-02-27

- 新站SEO優化怎么做可以快速被收錄? 2015-10-12

- 哪些原因導致網站收錄不好 2021-11-27

- 搜索引擎不收錄文章的原因有哪些? 2013-10-26

- 成都SEO網站一直不被收錄怎么辦 2016-10-28

- 讓搜索引擎快速收錄新內容的方法與技巧 2016-10-13

- 蜘蛛性格引領網站收錄 2023-01-22

- SEO優化網站怎么做才能吸引蜘蛛收錄更多的頁面? 2016-11-08

- 網站制作后期推廣您需要簡單的了解搜索引擎收錄的原理 2016-10-28

- 網站優化:網站為什么不收錄? 2016-11-04

- 成都網站建設后文章怎么樣快速被收錄 2016-10-26