ZooKeeper 原理與服務器集群部署

2021-01-29 分類: 網站建設

ZooKeeper 是大型分布式系統中可靠的協調系統,它以樹狀結構存儲數據,以領導選舉和信息同步機制保證了集群的高可用性,以事件通知機制協助事件訂閱者及時捕獲數據的變化,可協助實現 Dubbo、Kafka 等架構。本文以 CentOS 和 Windows 為例,總結了 ZooKeeper 集群的部署操作,并以自帶的腳本命令操作其數據。

1.概述

ZooKeeper 是 Hadoop 的一個子項目,是大型分布式系統中可靠的協調系統。分布式應用程序以此實現更高級別的服務,可用于分布式系統的配置維護、名字服務、分布式同步、組服務等:

用于 Dubbo: 作為配置中心;

用于 Kafka: 作為 Broker/Producer/Consumer 共享的配置中心。

官網首頁: https://zookeeper.apache.org/

官網文檔: https://zookeeper.apache.org/doc/current/

1.1 ZAB協議

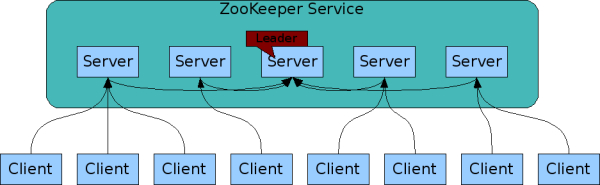

集群間通過 ZAB(ZooKeeper Atomic Broadcast)協議保持數據一致性,該協議包括兩個階段:

1.1.1 領導選舉(Leader Election)

選舉出一個 Leader(所有寫操作傳送給 Leader),其他機器被稱為 Follower;

當前 Leader 崩潰或失去大多數 Follower 后,會選舉出新的 Leader;

1.1.2 信息同步(Atomic broadcast)

用于同步 Leader 與 Follower 之間的信息,保證數據一致。

1.2 內部原理

https://zookeeper.apache.org/doc/current/zookeeperOver.html

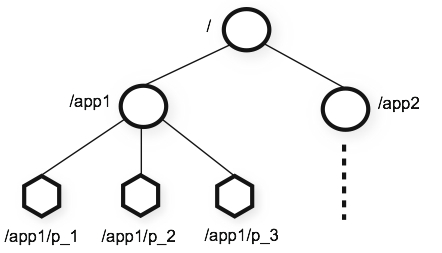

存儲方式與標準文件系統非常相似,每個節點稱作 znode,本身包含數據,還可以擁有子節點。

客戶端以TCP連接一臺節點,該節點故障時,客戶端會切換至其他節點。

客戶端可以訂閱某些節點的事件(watcher機制),當節點內容或其子節點有變化時,客戶端會收到通知。

- 高性能:多讀少寫的情況下,速度很快;存儲于內存中,并有持久存儲中的事務日志和快照;

- 高可用性(無中心化結構可避免單點故障): 個別節點故障不影響整體使用;

- 監視機制: 客戶端可以監視一個結點(node),當結點斷開或有修改時,客戶端會收到通知;

- 順序一致性: 來自客戶端的更新將按照它們發送的順序進行應用。

- 原子性: 保證數據完整、一致,更新成功或失敗,沒有部分結果。

- 單系統映像: 無論服務器連接到哪個服務器,客戶端都會看到相同的服務視圖。

- 可靠性: 一旦更新被應用,它將一直持續到客戶覆蓋更新。

- 及時性: 系統的客戶觀點在一定的時間范圍內保證是最新的。

1.3 系統要求

ZooKeeper 以 Java 版本運行,Java 版本要求為 1.6+;

支持的操作系統包括: GNU/Linux, Solaris, FreeBSD, Windows。

2.Linux 下安裝

https://zookeeper.apache.org/doc/current/zookeeperStarted.html

2.1 下載并解壓(35M)

2.2 設置環境變量

- ## sudo vim /etc/profile ## 所有用戶有效

- export ZOOKEEPER_HOME=/opt/zookeeper-3.4.11

- export PATH=$PATH:$ZOOKEEPER_HOME/bin

文件保存后,Linux用戶重新登錄后生效。

2.3 準備目錄與配置文件

- # sudo vim $ZOOKEEPER_HOME/bin/zkInit.sh

- # sudo -E sh $ZOOKEEPER_HOME/bin/zkInit.sh

- for INDEX in {1..3}; do

- sudo rm -rf $ZOOKEEPER_HOME/{data,logs}/$INDEX

- sudo mkdir -p $ZOOKEEPER_HOME/{data,logs}/$INDEX

- echo $INDEX | sudo tee $ZOOKEEPER_HOME/data/$INDEX/myid > /dev/null

- # zoo.cfg 參考: grep -v "^#" $ZOOKEEPER_HOME/conf/zoo_sample.cfg

- cat > $ZOOKEEPER_HOME/conf/zoo-$INDEX.cfg << EOF

- tickTime=2000 ## ZooKeeper 的最小時間單位(ms)

- initLimit=10 ## 投票選舉新 leader 的初始化時間(以 tickTime 為單位)

- syncLimit=5 ## Leader 檢測 Follower 可用性心跳的超時時間(以 tickTime 為單位)

- clientPort=218$INDEX ## 客戶端用來連接 ZooKeeper 的端口

- dataDir=$ZOOKEEPER_HOME/data/$INDEX ## 數據目錄(存儲內存數據庫快照)

- dataLogDir=$ZOOKEEPER_HOME/logs/$INDEX ## 日志目錄(存儲事務日志)

- server.1=localhost:2281:2291

- server.2=localhost:2282:2292

- server.3=localhost:2283:2293

- EOF

- done

其中的 clientPort=218$INDEX 是提供給客戶端連接的端口(2181,2182,2183);

其中的 server.N = hostname : port1 : port2:

- N(1,2,3): “必須”是一個數字(表示這是第幾號server),否則報錯 java.lang.NumberFormatException: For input string: "xxx"

- hostname(localhost): 是該 server 所在的域名或IP地址,為了通用,可替換為域名zk{n}.company.com 并在 hosts 里配置;

- port1(2281,2282,2283): 當前 server 是 leader 時,監聽此端口接受 followers 的連接,注意followers不會監聽此端口(直到它升級為 leader)

- port2(2291,2292,2293): 是選舉 leader 時所使用的端口。

必須生成文件 $ZOOKEEPER_HOME/data/%n/myid,其內容為 zoo.cnf 中的 N(服務器ID), 否則拋出異常 java.lang.IllegalArgumentException: $ZOOKEEPER_HOME/data/{n}/myid file is missing

2.4 服務的配置并啟動

- ## sudo vim /usr/lib/systemd/system/zookeeper@.service

- ## 其中的 %i 將來會被替換為具體的 1/2/3

- [Unit]

- Description=ZooKeeper

- After=syslog.target network.target

- [Service]

- Type=forking

- Environment="ZOOCFG=zoo-%i.cfg"

- ExecStart=/opt/zookeeper-3.4.11/bin/zkServer.sh start

- ExecStop=/opt/zookeeper-3.4.11/bin/zkServer.sh stop

- [Install]

- WantedBy=multi-user.target

配置為自動啟動,并立即啟動:

- sudo systemctl daemon-reload

- sudo systemctl enable zookeeper@{1,2,3}

- sudo systemctl start zookeeper@{1,2,3}

- sudo netstat -natp | grep LISTEN | grep -E "218|228|229"

- # sudo systemctl stop zookeeper@{1,2,3}

2.5 防火墻放行

如果非本機應用需要連接 ZooKeeper,必須把所有 clientPort 端口放行。

- ### sudo vim /etc/sysconfig/iptables

- -A INPUT -m state --state NEW -m tcp -p tcp --dport 2181 -j ACCEPT

- -A INPUT -m state --state NEW -m tcp -p tcp --dport 2182 -j ACCEPT

- -A INPUT -m state --state NEW -m tcp -p tcp --dport 2183 -j ACCEPT

- ### 重啟生效: sudo systemctl restart iptables

2.6 客戶端驗證

- zkCli.sh -server localhost:2181 ## 進入命令行狀態

- help ## 顯示所有命令格式

- quit ## 退出命令行狀態

- history ## 顯示歷史命令

- ls path [watch]

- createpath data acl

- delete path [version]

- set path data [version]

- get path [watch]

- stat path [watch]

- sync path

- listquota path

- setquota -n|-b val path

- delquota [-n|-b] path

- addauth scheme auth

- setAcl path acl

- getAcl path

- printwatches on|off

- redo cmdno

也可集連接和命令于一行:

- zkCli.sh -server localhost:2181 ls /

2.7 清空數據【慎用】

- sudo systemctl stop zookeeper@{1,2,3}

- sudo rm -rf $ZOOKEEPER_HOME/{logs,data}/{1,2,3}/version-*

- sudo systemctl start zookeeper@{1,2,3}

2.8 卸載服務【慎用】

- sudo systemctl stop zookeeper@{1,2,3}

- sudo systemctl disable zookeeper@{1,2,3}

- sudo rm -rf $ZOOKEEPER_HOME

3.Windows 下安裝(可用于開發)

3.1 下載

https://archive.apache.org/dist/zookeeper/

https://archive.apache.org/dist/zookeeper/zookeeper-3.4.11/

https://archive.apache.org/dist/zookeeper/zookeeper-3.4.11/zookeeper-3.4.11.tar.gz

3.2 安裝

3.2.1 解壓

3.2.2 修改系統環境變量

- set ZOOKEEPER_HOME={???}\zookeeper-3.4.11

- set PATH=%ZOOKEEPER_HOME%\bin

3.2.3 修改 conf\zoo-%n.cfg

- cd/d %ZOOKEEPER_HOME%

- del /q bin\*.sh

- rd/s/q data logs

- for %n in (1,2,3) do @mkdir logs\%n

- for %n in (1,2,3) do @mkdir data\%n

- for %n in (1,2,3) do @echo %n> data\%n\myid

- for %n in (1,2,3) do @copy/b conf\zoo_sample.cfg conf\zoo-%n.cfg

修改文件 conf\zoo-%n.cfg 如下(分別替換其中的 %n 為 1,2,3):

- tickTime=2000

- initLimit=10

- syncLimit=5

- clientPort=218%n

- dataDir=D:/Software/Architecture/zookeeper-3.4.11/data/%n

- dataLogDir=D:/Software/Architecture/zookeeper-3.4.11/logs/%n

- server.1=localhost:2281:2291

- server.2=localhost:2282:2292

- server.3=localhost:2283:2293

參數說明與 Linux 中相關內容一樣。

3.2.4 修改腳本

刪除 bin\zkEnv.cmd 中的 set ZOOCFG=%ZOOCFGDIR%\zoo.cfg 一行;

- for %n in (1,2,3) do @copy/b bin\zkServer.cmd bin\zkServer%n.cmd

修改各個文件 zkServer%n.cmd 在 call "%~dp0zkEnv.cmd" 之前加一行:

set ZOOCFG=%~dp0%..\conf\zoo-%n.cfg,注意替換 %n 分別為 1/2/3

3.3 啟動服務

- zkServer1.cmd

- zkServer2.cmd

- zkServer3.cmd

3.4 客戶端驗證

- zkCli.cmd -server centos:2181 ## 連接 Linux 上服務

- zkCli.cmd -server localhost:2181 ## 連接本機上服務

- ## 更多內容參見前面 Linux 中相應部分

4.集群部署(生產環境)

管理員指南: https://zookeeper.apache.org/doc/current/zookeeperAdmin.html

- 要求至少為三臺 ZooKeeper 服務器,最好是奇數個服務器(以便多數正常機器處理少數機器的故障),通常三臺足夠了,如果想更可靠,可增加至五臺;

- 為避免各服務器同時發生故障,最好部署在不同機器、不同網絡交換機(電路、冷卻系統等)、甚至不同機房;

- 為避免內存交換,要設置足夠大的 JVM 堆,比如 4G 機器可指定 3G;

分享題目:ZooKeeper 原理與服務器集群部署

分享鏈接:http://m.newbst.com/news5/98055.html

成都網站建設公司_創新互聯,為您提供網站維護、網站制作、標簽優化、電子商務、全網營銷推廣、小程序開發

聲明:本網站發布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創新互聯

猜你還喜歡下面的內容

- 作為網絡工程師必須牢記的幾個命令,新手福利來了 2021-01-29

- 編程的魅力 2021-01-29

- B2B企業營銷,越來越重要了 2021-01-29

- Html5模板建站好不好? 2021-01-29

- 開發中常用的 25 個JavaScript 單行代碼 2021-01-29

- 程序員用代碼寫合租廣告,這是一群注定要孤獨終老的群體 2021-01-29

- ”中國式SaaS“是怎樣的? 2021-01-29

- 程序員!生活真的不容易 2021-01-29

- 如何快速搭建Apache+php部署環境 2021-01-29

- 企業為什么要做SEO? 2021-01-29

- 災難恢復站點的作用和應用 2021-01-29

- 租用香港服務器的優點 2021-01-29

- 小程序電商煥發“第二春” 2021-01-29

- 流量成本高,電商行業該如何做營銷推廣? 2021-01-29

- 如何正確的選擇服務器的托管與租用 2021-01-29

- 移動互聯網主流商業模式:廣告、App、電商、企業定制 2021-01-29

- 你的Linux服務器果真得到保護了嗎? 2021-01-29

- 最新edge瀏覽器初體驗 2021-01-29

- 在線教育下半場的四大“圍城” 2021-01-29