收藏!盤點很實用的數據科學Python庫

2021-03-02 分類: 網站建設

數據科學是一門研究數據并從中挖掘信息的學科。它不要求自創(chuàng)或學習新的算法,只需要知道怎么樣研究數據并解決問題。這一過程的關鍵點之一就在于使用合適的庫。本文概述了數據科學中常用的、并且有一定重要性的庫。在進入正題之前,本文先介紹了解決數據科學問題的5個基本步驟。這些步驟是筆者自己總結撰寫的,并無對錯之分。步驟的正確與否取決于數據的研究方法。

數據科學的五個重要步驟包括:

1.獲取數據

2.清理數據

3.探索數據

4.構建數據

5.呈現數據

這五個步驟只是經驗之談,并不是什么標準答案。但是如果仔細思考,就會發(fā)現這五個步驟是非常合理的。

1. 獲取數據

獲取數據是解決數據科學問題的關鍵一步。你需要提出一個問題并最終解決它。這取決于你是如何以及從何處獲取數據的。獲取數據較好的方法就是從Kaggle上下載或從網絡上抓取。

當然,你也可以采用適當的方法和工具從網絡上抓取數據。

網絡數據抓取最重要、最常用的庫包括:

1.Beautiful Soup

2.Requests

3.Pandas

Beautiful Soup是一個可從HTML和XML文件中提取數據的Python庫。推薦讀者閱讀Beautiful Soup庫官方文檔。

如果已經安裝Python,只需輸入以下命令,即可安裝Beautiful Soup。文中所涉及的庫全部給出了安裝方法。但是我更推薦讀者使用Google Colab,便于練習代碼。在Google Colab中,無需手動安裝,只需要輸入“importlibrary_name”,Colab就會自動安裝。

pip install beautifulsoup4

導入Beautiful Soup庫:

from bs4 import BeautifulSoupSoup = BeautifulSoup(page_name.text, ‘html.parser’)

Python的Requests庫采用更加簡單易用的方式發(fā)送HTTP請求。Requests庫中有很多種方法,其中最常用的是request.get()。在URL轉發(fā)成功或失敗的情況下,request.get()都能夠返回URL轉發(fā)狀態(tài)。推薦讀者閱讀Requests庫官方文檔了解更多信息(https://realpython.com/python-requests/?source=post_page-----a58e90f1b4ba----------------------)。

安裝Requets:

pip install requests

導入Requests庫:

import requestspaga_name = requests.get('url_name')

Pandas是一種方便易用的高性能數據結構,同時也是Python編程語言分析工具。Pandas提供了一種能夠清晰、簡潔地存儲數據的數據框架。Pandas庫官方文檔如下:https://pandas.pydata.org/pandas-docs/stable/?source=post_page-----a58e90f1b4ba----------------------

安裝Pandas:

pip install pandas

導入Pandas庫:

import pandas as pd

2. 清理數據

清理數據有許多重要的步驟,往往包括清除重復行、清除異常值、查找缺失值和空值,以及將對象值轉換成空值并繪制成圖表等。

數據清理常用的庫包括:

1.Pandas

2.NumPy

Pandas可以說是數據科學中的“萬金油”——到處都可用。關于Pandas的介紹詳見上文,此處不再贅述。

NumPy即Numeric Python,是一個支持科學計算的Python庫。眾所周知,Python本身并不支持矩陣數據結構,而Python中的NumPy庫則支持創(chuàng)建和運行矩陣計算。NumPy庫官方文檔如下:https://numpy.org/devdocs/?source=post_page-----a58e90f1b4ba----------------------

運行以下命令下載NumPy(確保已經安裝了Python):

python -m pip install --user numpy scipy matplotlib ipython jupyter pandas sympy nose

導入NumPy庫:

import numpy as np

3. 探索數據

探索性數據分析(Exploratory Data Analysis, EDA)是用于增強信息索引理解的工具,通過有規(guī)律地刪減和用圖表繪制索引基本特征實現。使用EDA能夠幫助用戶更加深入、清晰地探索數據,展現重要信息采集的發(fā)布或情況。

運行EDA常用的庫包括:

1.Pandas

2.Seaborn

3.Matplotlib.pyplot

Pandas:詳見上文。

Seaborn是一個Python數據可視化庫,為繪制數據圖表提供了一個高級接口。安裝新版本的Seaborn:

pip install seaborn

使用Seaborn,可以輕松繪制條形圖、散點圖、熱力圖等圖表。導入Seaborn:

import seaborn as sns

Matplotlib是一個Python 2D圖形繪圖庫,能夠在多種環(huán)境中繪制圖表,可替代Seaborn。事實上,Seaborn是基于Matplotlib開發(fā)的。

安裝Matplotlib:

python -m pip install -U matplotlib

推薦閱讀Matplotlib官方文檔:https://matplotlib.org/users/index.html?source=post_page-----a58e90f1b4ba----------------------

導入Matplotlib.pyplot庫:

import matplotlib.pyplot as plt

4. 構建模型

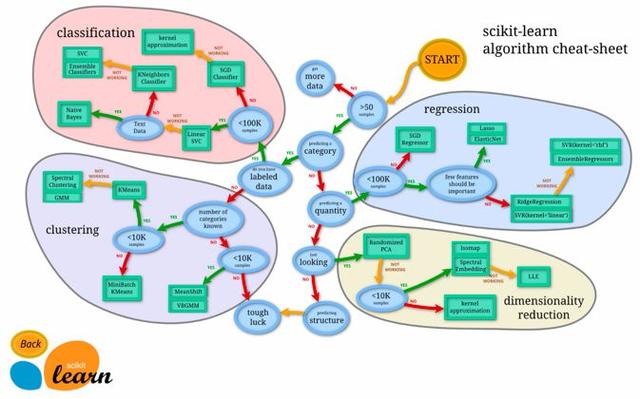

構建模型是數據科學中的關鍵一步。由于這一步要求根據要解決的問題和所獲取的數據來構建機器學習模型,所以和其他步驟相比難度更大。在這一步中,問題陳述是至關重要的一點,因為它會影響對問題的定義和提出的解決方法。網絡上大部分公開的數據集都是基于某一個問題收集的,因此解決問題的能力就尤為重要。而且,由于沒有某個特定的算法最適合自己,你需要在多種算法中進行選擇,考慮數據適合用回歸、分類、聚類還是降維算法。

選擇算法經常是一件讓人頭疼的事。讀者可以使用SciKit learn算法選擇路徑圖來記錄追蹤哪個算法的性能最優(yōu)。下圖展示了一張SciKit learn的路徑圖:

不難猜出,建模時最常用的庫是:

1.SciKit learn

SciKit learn是Python中一個便于使用的構建機器學習模型的庫。它是基于NumPy、SciPy和Matplotlib開發(fā)的。SciKit learn庫官方文檔如下:https://scikit-learn.org/stable/?source=post_page-----a58e90f1b4ba----------------------

導入scikit learn:

import sklearn

安裝scikit learn:

pip install -U scikit-learn

5. 呈現數據

這是數據科學的最后一步,也是很多人不想做的一步——畢竟沒有人想要公開發(fā)表他們的數據發(fā)現。呈現數據也是有法可循的,并且這個方法極為重要,因為無論如何,成果最終還是要向人們展示的。而且由于人們并不關心所使用的的算法,他們只關心結果,所以展示還要做到簡潔明了。為了展現數據成果,推薦讀者安裝Jupyter notebook:https://jupyter.org/install.html?source=post_page-----a58e90f1b4ba----------------------

同時,安裝如下指令給notebook配備展示選項:

pip install RISE

閱讀文章:http://www.blog.pythonlibrary.org/2018/09/25/creating-presentations-with-jupyter-notebook/,了解更多如何使用notebook做出精彩展示的教程。務必遵循教程的步驟。讀者還可以觀看Youtube的視頻進行學習:

以上就是本文全部內容。本文從最基礎的內容開始介紹,讀完全文,讀者已經知道了在數據科學中如何、在何時、以及在哪一步使用Python庫。

當前標題:收藏!盤點很實用的數據科學Python庫

文章路徑:http://m.newbst.com/news28/103728.html

成都網站建設公司_創(chuàng)新互聯,為您提供定制開發(fā)、App設計、品牌網站制作、面包屑導航、移動網站建設、服務器托管

聲明:本網站發(fā)布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創(chuàng)新互聯

猜你還喜歡下面的內容

- 企業(yè)官網建設要多少錢?步驟有哪些? 2021-03-02

- 電商如何利用好小程序做引流推廣和營銷 2021-03-02

- 跨境電商網站部署SSL證書迫在眉睫 2021-03-02

- 企業(yè)想做大,重產品還是重營銷? 2021-03-02

- 外貿網站怎么做優(yōu)化?這些技巧能讓你事半功倍 2021-03-02

- 寫ios和安卓系統的人到底有多牛? 2021-03-02

- 為什么進入測試行業(yè)要趁早? 2021-03-02

- 電腦cpu和手機cpu有什么區(qū)別,差距有多大? 2021-03-02

- 直銷公司選擇什么服務器,需要考慮什么 2021-03-02

- 5G消息服務入口在哪,你可能想不到 2021-03-02

- 快時尚的時代,過去了? 2021-03-02

- 域名投資掌握什么技巧?行業(yè)大佬都是怎么投資域名? 2021-03-02

- 新基建:之云計算,風起“云”涌,驅動未來,關注產業(yè)鏈投資機會 2021-03-02

- 做電商為什么一定要申請商標 2021-03-02

- 解決百度算法更新的折磨 2021-03-02

- 域名國家工程研究中心主任毛偉解讀.net”斷網”事件 2021-03-02

- 企業(yè)該不該選擇SAAS服務? 2021-03-02

- 百度SEO,長期真的有效果嗎? 2021-03-02

- 云計算對社會的改變,企業(yè)如何發(fā)展云計算 2021-03-02